Генеративные нейросети, такие как DALL-E, Midjourney и Stable Diffusion, становятся все более совершенными в создании реалистичных изображений. Это приносит новые вызовы, связанные с возможностью создания фальшивых изображений (дипфейков), которые могут быть использованы для дезинформации или манипуляции общественным мнением. В этой инструкции мы рассмотрим основные инструменты и методы, которые помогут вам распознать изображения, созданные нейросетями.

дисклеймер

При анализе дипфейков важно учитывать тот факт, что при всём обилии технических инструментов для их распознавания, все они лишь с большей или меньшей точностью оценивают вероятность того, что фото сгенерировано машиной. Технологии создания подобных фейков всегда немного опережают технологии их распознавания. Поэтому важным элементом анализа таких изображений остаётся насмотренность и внимательность проверяющего.

Визуальные признаки сгенерированных изображений

Анатомические ошибки

Одним из первых признаков сгенерированного изображения могут быть анатомические несоответствия. Нейросети часто ошибаются при отрисовке рук, ног, пальцев и других частей тела. На сгенерированных изображениях люди могут иметь шесть пальцев или неправильно сформированные уши. Обратите внимание на:

- Руки и пальцы: избыточное количество пальцев или неправильные пропорции.

- Глаза и уши: асимметрия, неправильное положение или форма.

- Зубы: резцы на месте клыков и наоборот.

Так, множество подобных ошибок было на сгенерированных Элиоттом Хиггинсом изображениях «ареста и побега Дональда Трампа», ставших вирусными в 2023 году.

При ближайшем рассмотрении видны детали, которые выдают неаутентичность фотографий. На одном снимке у Трампа нет кисти, на другом — нет предплечья и плеча, а на третьем он сам одет в полицейскую форму.

Как говорил сам Хиггинс в беседе с AFP: «На самом деле изображение ареста Трампа просто показало, насколько хороша и одновременно плоха Midjourney в визуализации реальных сцен. Например, на первом изображении Трамп с тремя ногами и полицейским ремнём. Я предполагал, что люди поймут, что у Дональда Трампа две ноги, а не три. Однако, похоже, это не помешало некоторым выдать картинки за настоящие [фото], что подчёркивает отсутствие навыков критического мышления в нашей образовательной системе»..

Схожие ошибки можно обнаружить и на «фото» с кланяющимся Си Цзиньпину Путиным, или папы римского Франциска в белом пуховике, которые «Проверено» также анализировало.

Текст

Довольно часто нейросети не справляются с текстовыми элементами. Тексты на вывесках или других элементах изображения получается либо бесмысленным набором символов, либо каракулями.

Инструменты для распознавания ИИ-изображений

Huggingface AI Image Detector

Maybe's AI Art Detector от Huggingface оценивает вероятность того, что изображение было создано нейросетью. Этот инструмент выводит результат в процентах, что может быть полезно для быстрой оценки изображения. Однако важно помнить, что он (как и другие инструменты) не дает 100% точного результата. Так, в нашем тесте он хорошо справлялся с искусственными изображениями (показывая вероятность в 99%), но анализируя реальные фото, выдавал до 50% вероятности, что они сгенерировано нейросетью, а не сняты человеком.

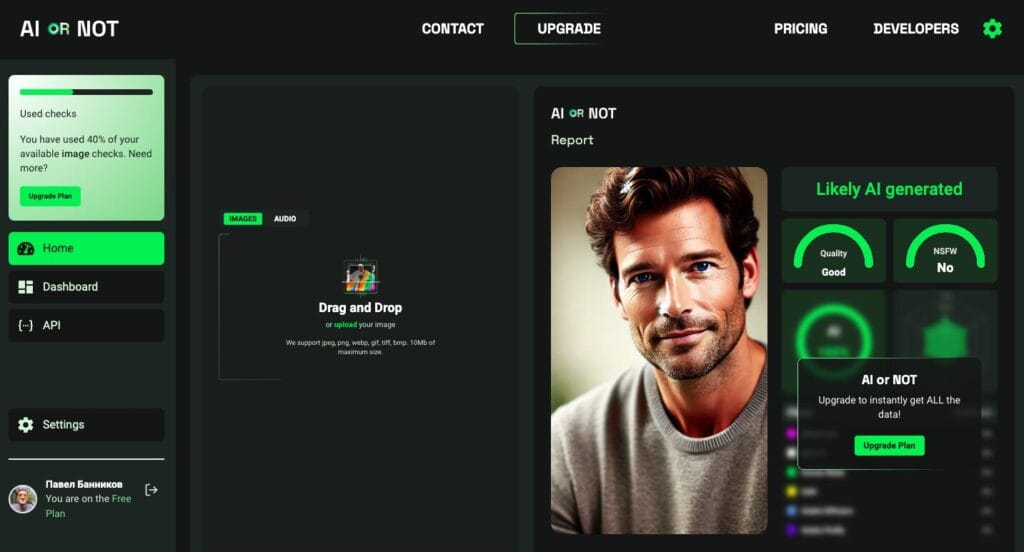

Aiornot.com

Aiornot.com предлагает вилку ответов между «это вероятно ИИ» и «это снял человек». Этот инструмент хорошо справляется с распознаванием лиц, созданных нейросетью (наш тест показал 8 из 10), с настоящими фото (10 из 10), но слишком часто ошибается при анализе изображений объектов или животных.

Их приятных бонусов: на момент публикации статьи, этот инструмент работает с форматом .webp, а также с аудиофайлами и роликами с YouTube, то есть, может оценить вероятность подделки аудио или видеозаписи. Из неприятных — в бесплатной версии доступно только 10 проверок в месяц и нет расширенного анализа. Платная начинается от $5 в месяц.

Content Credentials

Content Credentials разработан на основе стандарта C2PA, поддерживаемого компаниями Adobe, Microsoft и OpenAI. Этот инструмент позволяет загружать изображения и другие файлы, и обещает проверять их подлинность, даже если они были отредактированы или лишены метаданных. К сожалению, в тесте «Проверено», проведённом в августе 2024 этот инструмент показал себя хуже всех — изменения в метаданных или формате файла приводили к тому, что Content Credentials попросту не выдавал никакой полезной информации. Возможно, это было связано с техническим сбоем.

Другие методы анализа

Обратный поиск изображений

Если вы сомневаетесь в подлинности снимка, обратный поиск по изображениям через такие инструменты, как Google Image Search или TinEye, может помочь найти оригинал изображения и выяснить, использовалось ли оно ранее в другом контексте.

Проверка на наличие водяных знаков

Некоторые компании добавляют водяные знаки на изображения, созданные нейросетями. Эти водяные знаки могут быть полезным индикатором. Внимательно изучите углы и края изображения на наличие водяных знаков.

Анализ метаданных (EXIF)

Метаданные содержат информацию о настройках камеры, времени и месте съемки, которые могут указать на подлинность изображения. Если метаданные отсутствуют или были изменены, это может быть признаком того, что изображение сгенерировано или отредактировано. Метаданные можно увидеть при просмотре свойств файла на компьютере иди с помощью одного из специальных сервисов.

Логика и насмотренность — ваши главные помощники

Независимо от использования инструментов, важнейшим элементом в распознавании сгенерированных изображений остается логика и насмотренность. Тренируйтесь в анализе изображений, обращайте внимание на детали и используйте инструменты в сочетании с критическим мышлением. Контекст изображения имеет значение.

Фото на обложке: коллаж «Проверено» / соцсети / trippy_art_special / @EliotHiggins